Что такое речевой интерфейс

Что такое голосовые технологии и интерфейсы

Голосовой интерфейс – это программный продукт, который при помощи голосовой или речевой платформы позволяет взаимодействовать пользователю и компьютеру, запуская автоматизированные процессы. Задача таких интерфейсов – распознать и генерировать голос человека.

Голосовые интерфейсы удобны, когда вводить текст сложно или неудобно. Например, во время вождения автомобиля пользователь может проговорить свой запрос, продиктовать нужный адрес, проверить пробки в приложении навигатора. Или же если пользователь выполняет слишком много задач и не может сконцентрироваться на одной.

UX-исследователь и экс-специалист по речевым интерфейсам в Google Константин Самойлов в своем докладе, подготовленном для UX-марафона «Взаимодействие будущего», назвал три важных признака, которыми должны обладать голосовые интерфейсы:

На момент написания это й статьи основные голосовые игроки – это Alexa Amazon, Siri Apple, OK Google, Кортана Microsoft. В октябре 2017 года компания Яндекс официально запустила голосового помощника «Алиса». В отличие от аналога Siri «Алиса» целенаправленно создана для русскоязычной аудитории.

«Роль голоса в онлайновой коммуникации нарастает медленно, но верно. Это и «OK, Google», и внедрение голосовых сообщений в мессенджеры, и появление аудиоверсий у текстовых публикаций, и голосовой ввод во все большем количестве программ, и звуковые колонки, которые умнеют на глазах и становятся понятливыми ассистентами и собеседниками. Вообще, история про девайсы, программы и голос – очень толстый тренд, который полезно использовать, а не игнорировать», пишет в своем телеграм-канале директор по маркетингу сервисов компании «Яндекс» Андрей Себрант.

Интересно, что поколение Z (родившиеся в начале 2000-х годов) и ранние представители поколения «альфа» (дети, рожденные после 2010-х годов) – это последние пользователи, которые будут набирать тексты с помощью клавиатуры.

В этом уверен обозреватель Marketingland, маркетолог Эндрю Руггер (Andrew Ruegger), об этом он написал в своей колонке. Следующее поколение, по его мнению, будут представлять исключительно пользователи голосовых команд. «Запросы типа «ОK, Google» становятся все более распространенными в отчетах поисковых запросов. И мы даже наблюдаем их рост в Google Trends», – пишет эксперт.

Именно поэтому цифровые технологии стараются слушать команды, которые человек говорит, определять эмоции по лицу, тем самым использовать натуральный способ взаимодействия с пользователями. Например, компания Google в октябре 2017 года презентовала беспроводные наушники Pixel Buds, которые переводят речь с иностранного языка в режиме реального времени.

Разновидности пользовательского интерфейса

Вы будете перенаправлены на Автор24

К основным типам пользовательского интерфейса относятся:

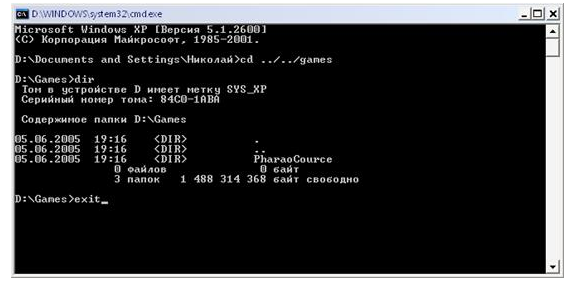

Командный интерфейс

Наиболее старым интерфейсом является командный интерфейс (интерфейс командной строки), который был наиболее распространен в период расцвета больших многопользовательских систем с алфавитно-цифровыми дисплеями. Для командного интерфейса характерно взаимодействие пользователя с ЭВМ с помощью командной строки, в которую вводятся команды определенного формата, а затем передаются к исполнению.

Командный интерфейс реализован в виде пакетной технологии и технологии командной строки.

Для ввода информации пользователь использует клавиатуру или другое символьное устройство ввода. Пользователь получает информацию в виде текста посредством дисплея или печатающего устройства (довольно редко).

Рисунок 1. Пример командного интерфейса

Работа с командным интерфейсом заключалась в следующем:

Интересной особенностью интерфейса командной строки является возможность взаимодействия двух программ посредством имитации управляющей программой действий пользователя. Простота подачи команд и анализа выводимого текста делает это весьма эффективным.

К преимуществам интерфейса командной строки относят:

Готовые работы на аналогичную тему

Недостатками командного интерфейса считают:

Наиболее часто командный интерфейс используется при работе с командным интерпретатором, который используется как интерфейс управления операционной системой (Linux, xBSD, QNX, MS-DOS и др.).

Графический интерфейс пользователя

Графический интерфейс, WIMP-интерфейс (Window Image Menu Pointer) является неотъемлемым компонентом большинства современного программного обеспечения, которые ориентированы на работу конечного пользователя. Диалог пользователя с ПК в графическом интерфейсе ведется при помощи графических объектов: меню, значков и других элементов.

Основные достоинства графического интерфейса:

При работе с графическим интерфейсом для манипуляций с графическими объектами используются мышь и клавиатура. Пользователь работает с экранными формами, которые содержат объекты управления, меню, панели инструментов.

Рисунок 2. Пример графического интерфейса

Речевой интерфейс

Речевой интерфейс, SILK-интерфейс (Speech Image Language Knowledge) на данный момент существует только как «голосовой» (не считая биометрические интерфейсы, которые применяются не для управления ПК, а только для идентификации пользователя). Использование речевого интерфейса является очень перспективным направлением, т.к. введение информации с помощью голоса – самый быстрый и удобный способ. Т.к. качество распознавания устной речи пока не идеально, практическая реализация речевого интерфейса еще не стали доминирующими.

Речевой интерфейс обеспечивает приближенную к обычной, человеческой форму общения. ПК анализирует человеческую речь, находит в ней ключевые слова, по которым определяет команды. Речевой интерфейс требует высоких показателей аппаратных ресурсов ПК, поэтому его использование пока ограничено военным делом.

При использовании речевого интерфейса на экране по команде пользователя ПК осуществляет переход между поисковыми образами, используя смысловые семантические связи. Речевая система дает возможность повысить эффективность работы вследствие того, что:

Современные операционные системы поддерживают командный, графический и речевой интерфейсы.

В последнее время внимание привлекают новые виды интерфейса, такие как биометрический (мимический) и семантический (общественный). В связи с этим поставлена проблема создания общественного интерфейса, который будет включать в себя лучшие решения графического и речевого интерфейсов.

Концепция голосового интерфейса управления вычислительной системой для помощи людям с нарушениями речи

Введение

В настоящее время большое внимание уделяется созданию доступной среды для людей с инвалидностью и ограниченными возможностями здоровья. Важным средством обеспечения доступности и улучшения качества жизни, социального взаимодействия, интеграции в общество для людей с инвалидностью являются средства вычислительной техники и специализированные информационные системы. Анализ литературы показал, что на сегодняшний день ведутся различные разработки для облегчения взаимодействия человека и компьютера, в том числе в направлении разработки голосовых интерфейсов управления вычислительной системой. Однако, данные разработки ориентируются на создание дикторонезависимых систем, обучаемых на больших данных и не учитывающих особенности произношения команд компьютеру людьми с различными нарушениями речевых функций.

Целью научно-исследовательской работы является проектирование дикторозависимого голосового интерфейса управления вычислительной системой на основе методов машинного обучения.

Задачи, решаемые в работе:

Голосовой интерфейс как способ управления вычислительной системой

Создание систем распознавания речи представляет собой чрезвычайно сложную задачу. Особенно трудно распознать русский язык, имеющий множество особенностей. Все системы распознавания речи можно разделить на два класса:

Системы, зависимые от диктора — настраиваются на речь диктора в процессе обучения. Для работы с другим диктором такие системы требуют полной перенастройки.

Системы, независимые от диктора — работа которых не зависит от диктора. Такие системы не требуют предварительного обучения и способны распознавать речь любого диктора.

Изначально на рынке появились системы первого вида. В них звуковой образ команды хранился в виде целостного эталона. Для сравнения неизвестного произнесения и эталона команды использовались методы динамического программирования. Эти системы хорошо работали при распознавании небольших наборов из 10-30 команд и понимали только одного диктора. Для работы с другим диктором эти системы требовали полной перенастройки.

Для того чтобы понимать слитную речь, необходимо было перейти к словарям гораздо больших размеров, от нескольких десятков до сотен тысяч слов. Методы, использовавшиеся в системах первого вида, не подходили для решения этой задачи, так как просто невозможно создать эталоны для такого количества слов.

Для того чтобы понимать слитную речь, необходимо было перейти к словарям гораздо больших размеров, от нескольких десятков до сотен тысяч слов. Методы, использовавшиеся в системах первого вида, не подходили для решения этой задачи, так как просто невозможно создать эталоны для такого количества слов.

Кроме этого, существовало желание сделать систему, не зависящую от диктора. Это весьма сложная задача, поскольку у каждого человека индивидуальная манера произнесения: темп речи, тембр голоса, особенности произношения. Такие различия называются вариативностью речи. Чтобы ее учесть, были предложены новые статистические методы, опирающиеся в основном на математические аппараты Скрытых Марковских Моделей (СММ) или Искусственных Нейронных сетей. Наилучшие результаты достигнуты при комбинировании этих двух методов. Вместо создания эталонов для каждого слова, создаются эталоны отдельных звуков, из которых состоят слова, так называемые акустические модели. Акустические модели формируются путём статистической обработки больших речевых баз данных, содержащих записи речи сотен людей. В существующих системах распознавания речи используются два принципиально разных подхода:

Распознавание голосовых меток — распознавание фрагментов речи по заранее записанному образцу. Этот подход широко используется в относительно простых системах, предназначенных для исполнения заранее записанных речевых команд.

Распознавание лексических элементов — выделение из речи простейших лексических элементов, таких как фонемы и аллофоны. Этот подход пригоден для создания систем диктовки текста, в которых происходит полное преобразование произнесенных звуков в текст.

Обзор различных интернет-источников позволяет выделить следующие программные продукты, решающие задачи распознавания речи и их основные характеристики:

Горыныч ПРОФ 3.0 — это простая в использовании программа, для распознавания устной речи и набора текста путем диктовки с поддержкой русского языка. В ее основе лежат российские разработки в области распознавания устной речи.

Математический аппарат распознавания состояния диктора и его особенностей

Для решения задачи, поставленной в работе, проанализируем требования к системе.

Система должна быть:

Голосовые команды являются звуковой волной. Звуковую волну можно представить в виде спектра входящих в нее частот. Цифровой звук – это способ представления электрического сигнала посредством дискретных численных значений его амплитуды. В качестве входной информации для работы голосового интерфейса выступает звуковой файл в оперативной памяти, в результате подачи файла на нейронную сеть программа выдает соответствующий результат.

Оцифровка – это фиксация амплитуды сигнала через определенные промежутки времени и регистрация полученных значений амплитуды в виде округленных цифровых значений. Оцифровка сигнала включает в себя два процесса — процесс дискретизации и процесс квантования.

Процесс дискретизации – это процесс получения значений сигнала, который преобразуется с определенным временным шагом, такой шаг называется шагом дискретизации. Количество измерений величины сигнала, выполняемых в одну секунду, называют частотой дискретизации или частотой выборки, или частотой семплирования. Чем меньше шаг дискретизации, тем выше частота дискретизации и тем более точное представление о сигнале нами будет получено.

Квантование – это процесс замены реальных значений амплитуды сигнала приближенными с некоторой точностью значениями. Каждый из 2N возможных уровней называется уровнем квантования, а расстояние между двумя ближайшими уровнями квантования называется шагом квантования. Если амплитудная шкала разбита на уровни линейно, квантование называют линейным или однородным.

Записанные значения амплитуды сигнала называются отсчетами. Чем выше частота дискретизации и чем больше уровней квантования, тем более точное представление сигнала в цифровой форме.

В качестве математического аппарата решения задачи выделения характеризующих признаков целесообразно использовать нейронную сеть, которая сможет обучиться и автоматически выделить необходимые признаки. Это позволит обучать систему под особенности произношения речевых команд конкретного пользователя. Сравнивая механизмы различных нейронных сетей, нами выбраны две наиболее подходящие. Это сеть Коско и Кохокена.

Самоорганизующаяся карта Кохонена — нейронная сеть с обучением без учителя, выполняющая задачу визуализации и кластеризации. Является методом проецирования многомерного пространства в пространство с более низкой размерностью (чаще всего, двумерное), применяется также для решения задач моделирования, прогнозирования, выявление наборов независимых признаков, поиска закономерностей в больших массивах данных, разработке компьютерных игр. Является одной из версий нейронных сетей Кохонена.

Сеть Кохонена является подходящей сетью, так как данная сеть может провести автоматическое разбиение обучающих примеров на кластеры, где количество кластеров задается пользователем. После обучения сети можно рассчитать к какому кластеру относится входной пример, и вывести соответствующий результат.

Нейронная сеть Коско или двунаправленная ассоциативная память (ДАП) — однослойная нейронная сеть с обратными связями, базируется на двух идеях: адаптивной резонансной теории Стефана Гросберга и автоассоциативной памяти Хопфилда. ДАП является гетероассоциативной: входной вектор поступает на один набор нейронов, а соответствующий выходной вектор вырабатывается на другом наборе нейронов. Как и сеть Хопфилда, ДАП способна к обобщению, вырабатывая правильные реакции, несмотря на искаженные входы. Кроме того, могут быть реализованы адаптивные версии ДАП, выделяющие эталонный образ из зашумленных экземпляров. Эти возможности сильно напоминают процесс мышления человека и позволяют искусственным нейронным сетям сделать шаг в направлении моделирования мозга.

Преимущество этой сети является в том, что основе дискретных нейронных сетей адаптивной резонансной теории разработана новая двунаправленная ассоциативная память, способная запоминать новую информацию без переобучения нейронной сети. Это позволяет пользователю пополнять запас голосовых меток в случае необходимости.

Проектирование

Концепция программной реализации содержит три этапа, которые реализуются в одном программном продукте, имеющем эргономичный графический интерфейс.

Сбор обучающих примеров.

Для обучения нейросети пользователю предлагается произнести несколько раз заготовленные голосовые метки. Так как записываемые фразы состоят из одного слова, то размер файла не имеет значения. И для дальнейшей обработки звук записывается в формат WAV. Это PCM формат записи без потерь. Он является стандартом для дальнейшей обработки звука с помощью библиотеки python_speech_features языка Python. К аудиофайлу должно прилагаться его “значение”, необходимое для дальнейшего обучения нейросети (соответствующие команды).

Обучение нейронной сети.

Программа считывает аудиофайлы, и производит генерацию новых аудиофайлов путем изменения длины звуковой дорожки, а также изменение высоты, громкости и тембра речи. Это необходимо для увеличения количества примеров для обучающей выборки, что позволит увеличить качество распознавания нейронной сетью. В программе пользователю будет предложено обучить сеть на записанных ранее голосовых метках. Пользователь может также дополнять базу обучающими голосовыми метками, и дообучить нейронную сеть позднее.

После обучения программы на заданных словах, пользователь может приступить к работе или добавить на обучение новые голосовые метки. Обученная нейронная сеть может распознать подаваемые звуковые файлы.

Заключение

Таким образом, в научно-исследовательской работе проведен обзор современного рынка голосовых интерфейсов и сфер их использования. Показано, что данный вид программного обеспечения ориентирован на использование в системах дикторонезависимого голосового управления и не учитывает индивидуальных особенностей пользователя, что особенно актуально для людей с ограниченными возможностями здоровья и имеющих речевые нарушения.

Определены требования к голосовому интерфейсу управления вычислительной системой для помощи людям с нарушениями речи.

Описан математический аппарат, подходящий для реализации концепции. Составлен алгоритм программной реализации голосового интерфейса.

Дальнейшее развитие предполагает разработку программы с удобным графическим интерфейсом для реализации прототипа голосового интерфейса управления, который может быть использован для различных задач, таких как управление бытовыми приборами, компьютером, роботизированной техникой (экзоскелетами) людьми с инвалидностью.

Преимущества и недостатки голосовых интерфейсов

Пересказ доклада UX-исследователя и экс-специалиста по речевым интерфейсам в Google Константина Самойлова о возможностях существующих виртуальных ассистентов.

Доклад рассказан на UX-марафоне «Взаимодействие будущего» 6 июля 2017 года, когда голосового помощника «Яндекса» ещё не было.

Чтобы не было путаницы, важно договориться, что в принципе понимается под голосовым интерфейсом (ГИ). Задача распознавания голоса активно решается. Его качество даже для не английского языка в неидеальных условиях (с акцентами и интонациями) составляет 95−98%. Если натренировать модель, качество можно повысить.

Кроме распознавания и генерации голоса есть три составляющих, о которых часто забывают. Без них голосовое взаимодействие с системой практически невозможно.

Если говорить о ГИ как о замене печатания на клавиатуре или касания экрана, реализовать его просто — достаточно реализовать ввод команд голосом.

Но это не будет работать, так как язык команд не естественен для человека. В понимании пользователей преимущество голосового интерфейса заключается в том, что ему не надо учиться. Мы умеем говорить, мы — эксперты по взаимодействию друг с другом.

Сейчас язык взаимодействия со всеми существующими системами не естественный. Можно сказать «Алекса, начни играть такой-то трек», но это определённая грамматика, которой обучена система и которая на самом деле скрыта от пользователя.

Даже если мы можем голосом передавать команды в компьютер, система всё равно не будет работать. Предполагается, что все данные вводятся в самом начале. В программировании, если разработчик ввёл неправильную команду, система не уточняет, что именно он имел в виду. Как правило, она просто не работает. Должен быть диалог.

Та же Alexa работает на маленьком островке ответственности. В соответствии с заложенными алгоритмами она ожидает получить от пользователя определённые аргументы. Ожидания системы ограничивают грамматику и словарный запас, которые пользователь может использовать.

В Google разработчики продумали, какую грамматику и типы слов в английском языке могут использовать люди для самых распространённых задач — вроде установки будильника или создания напоминания.

Четыре года назад начали проводить тесты. На первом же тесте пользователь сказал что-то, чего разработчики не планировали. Система не сработала, разработчики сказали: «Чёрт, мы об этом не подумали».

Через три года в улучшенной версии той же системы пользователь снова произнёс что-то такое, от чего она не сработала, и разработчики сказали: «Чёрт, об этом мы тоже не подумали». Шло время, развивалось дерево решений и грамматики для конкретной задачи, и каждый новый тест выявлял исключение, которое не учитывали разработчики.

Естественный язык, диалог и словарный запас с грамматикой — фундаментальные вопросы, которые надо решить, чтобы ГИ на самом деле работал.

В обсуждениях голосовых и диалоговых интерфейсов обычно затрагивают целый спектр систем. Начиная с ботов, которые отвечают на самые простые вопросы и невпопад шутят, и заканчивая сложными системами, которые используются на промышленном уровне. Например, на удивление хорошая система подачи налоговой декларации в Англии.

Samsung делает свою новую систему под названием Vera. Alibaba — помощника для китайских пользователей. Рынок взорвался, все работают в этой области.

Но возникла парадоксальная ситуация. Компании, обладающие ресурсами, знаниями и навыками для значительного шага вперёд и сильного изменения индустрии, не заинтересованы в этом шаге. ГИ и голосовые ассистенты — инновация, которая меняет текущее положение дел (disruptive technology).

Google зарабатывает на рекламе. Если вместо ссылок, рядом с которыми показывается реклама, пользователи станут получать готовый ответ, возникнет вопрос — что делать с рекламой.

Siri — достаточно хороший ассистент, который стимулирует продажи iPhone. Она выполняет свои задачи, и компании нет смысла делать что-то новое, что изменит экосистему приложений App Store.

Нынешняя модель взаимодействия человека с компьютером — ящик с инструментами. Мы находим инструмент, кладём его в ящик и в определённый момент используем для достижения цели. Мы сами отвечаем за поиск и владение инструментами и сами должны понимать, когда и в какой последовательности их использовать.

Преимущество ГИ в том, что мы выражаем своё желание естественным образом. Естественно сказать «Дорогая, принеси мне, пожалуйста, чай» — мы говорим о нужном результате, а не проговариваем все шаги, которые для этого необходимы.

Фундаментальное изменение модели взаимодействия приведёт к тому, что отдельные инструменты будут не нужны.

Пользователи ожидают, что можно естественным образом выражать свои желания, а система будет их понимать. Система должна подстраиваться под человека, а не наоборот. Поэтому проектирование ГИ — это в большей степени работа над пониманием человеческих особенностей.

Одна девушка трижды участвовала в тестировании. Во второй раз, когда система уже работала достаточно хорошо, её реакция была «О боже мой, эта штука живёт в моём телефоне, теперь моя жизнь изменится». На третьем тестировании спустя месяц она сказала, что ни разу не использовала систему и не собирается.

Хоть система и работала в большинстве случаев, девушка ей просто не доверяла. Доверие — не технический вопрос, но если его не решить, вся остальная работа будет проделана зря.

Доверие противоположно контролю. Поговорка «Доверяй, но проверяй» — нонсенс. Не бывает, чтобы вы пришли домой и жена вам сказала: «Дорогой, ты вернулся в 12 часов ночи. Ты говорил, что на совещании. Поэтому я позвонила всем твоим друзьям, в твою компанию и твоему водителю, и ты действительно был на совещании. Я тебе доверяю, но проверяю». Такого не бывает.

Сначала мы узнаём, как система справляется, а потом начинаем делегировать ей задачи. Она становится чёрным ящиком — мы не знаем, как она это делает. Как и с живым ассистентом, мы отдаём контроль и заменяем его доверием.

Даже простая задача вроде установки будильника в определённом контексте не может быть так же легко делегирована. Одно дело — поставить будильник на субботу, чтобы просто не проспать до полудня. Другое — на 5 утра, чтобы приехать в аэропорт и встретить родителей. Люди не понимали, насколько система может ошибаться, поэтому не использовали её вовсе.

Уникальность голосового интерфейса в том, что он невидимый. В графическом интерфейсе мы видим элементы управления: есть ли они, как выглядят, современный ли дизайн, есть ли кнопки «Назад» и «Вперёд», на каком шаге мы сейчас находимся — промежуточном или конечном.

ГИ не позволяет этого увидеть. Мы пытаемся создать умственную модель системы и ответить на вопросы вроде: «Если сейчас я скажу “Назад”, то попаду в начало диалога или в предыдущее состояние? И что это за состояние?».

Умственная модель отвечает на вопрос о возможностях системы. Причём эта модель всегда неправильная. Если мы только что общались с голосовым меню «Нажмите один, чтобы что-то», ожидания будут занижены. Если мы недавно смотрели фильм «Она», ожидания будут завышены.

Чтобы ГИ хоть как-то работал, необходимо помогать пользователю создать и скорректировать умственную модель системы.

Система может задавать вопросы, предполагающие простые ответы:

— Вы хотите сохранить событие в календаре?

А возможно, предполагающие развёрнутые ответы:

— Вы хотите сделать что-то ещё?

— Перенеси это событие на полчаса вперёд.

Из формата вопроса пользователь может сделать вывод, что в первом случае система довольно глупая. Он скажет «Нет, не сохранять» и последующие команды будет давать с такой же гранулярностью: «Новое событие. Когда хотите сделать? В 12:30. Что хотите сделать? Встретить родителей. Где? В аэропорту».

Во втором случае он может решить, что система «умная» и понимает развёрнутые ответы. Для корректировки введённой информации он скажет: «Вместо этого я хочу сделать новое событие на завтра, на 12:30, чтобы встретить родителей в аэропорту».

Чтобы сделать ГИ, который естественен для человека, нужно понять, почему наш разговор с другим человеком считается естественным. За счёт каких характеристик? Мы поняли, что не знаем этого.

Есть умные люди, с которыми приятно общаться и с которыми нет. Есть люди с достаточно зрелыми реакциями: они иначе реагируют на наши ошибки и вопросы. 50 лет назад не было такого понятия, как эмоциональный интеллект. Наверняка мы не знаем многих других характеристик, благодаря которым мы можем комфортно общаться с другими людьми.

Не зная этих характеристик, нельзя внести их в систему и сделать общение с системой естественным. Один из возможных выходов — система не обязательно должна быть готовой. Можно выпустить полуфабрикат, который будет получать обратную связь от людей и узнавать, что он сделал правильно и неправильно.

Несмотря на то, что мы не знаем, какими эти характеристики должны быть, в какой-то момент система сама их выяснит и будет поддерживать.

Один из самых популярных вопросов — характер личности голосового ассистента. Сейчас технологии позволяют только имитировать дружелюбность, интеллектуальность, чувство юмора и так далее. Особенность человека в том, что это очень многоплановые характеристики. Подходы компаний разнятся и зависят от цели создания голосовой системы и философии компании.

Siri — проект компании, которая создаёт магический пользовательский опыт. Всё должно просто работать. И если пользователь угадывает с грамматикой и словарём, всё замечательно. Но если не угадывает, система перестаёт работать без малейшего указания на то, что не так и как скорректировать поведение, чтобы в следующий раз она работала лучше.

При этом огромное внимание уделено персоналити. Программисты работали над качеством голоса и человечным взаимодействием: Siri может пошутить, добавить забавный комментарий при выполнении стандартной задачи. Иногда это выглядит естественно, но мы быстро достигаем uncanny valley («зловещей долины»).

Эффект такой: чем больше система похожа на человека, тем больше она ему нравится. Но когда она становится очень похожей, приязнь резко снижается и восстанавливается только для полной имитации. Этот спад и называется «зловещей долиной».

С персоналити мы быстро в неё сваливаемся: система удачно шутит, человек расслабляется, использует другой набор слов и грамматику, и система начинает реагировать не так, как он ожидает. Пользователь может посчитать, что система над ним смеётся или не одобряет. Это намного хуже, чем если бы он просто думал, что перед ним глупый робот.

Одно из основных отличий ассистента Google в том, что у него даже нет имени (OK, Google). У Siri (Apple) и Alexa (Amazon) есть имена, и они пытаются вести себя как человек.

В Google мы пришли к выводу, что безопаснее всего не имитировать персоналити и показать пользователю, что это просто технологии без какого-либо человеческого общения.

Интересные решения есть у Alexa: она может контактировать с устройствами, которые есть дома, например, с «умным» замком. Можно подойти к двери и сказать: «Алекса, открой дверь, код такой-то».

Есть куча нюансов. Когда мы используем голос, нас слышат все, кто находится поблизости — это небезопасно и иногда неуместно. Люди используют ГИ у себя в машине для создания события, но не делают этого в автобусе, так как окружающие услышат, где, когда и с кем они планируют быть.

Мы решили не использовать ГИ, когда важна безопасность. В этом случае требования к системе выше. Если мы ставим будильник, и он срабатывает в 99 случаях из 100, это нормально. Если закрываем машину или сейф, срабатывание в 99 случаях из 100 неприемлемо.

Появляется вопрос обратной связи. Если мы ставим будильник, достаточно ответа, что он поставлен. Мы не уточняем все записанные системой параметры. При повышенных требованиях к безопасности мы должны полностью доверять системе, что невозможно в текущем состоянии.

Либо должны получать обратную связь: включена сигнализация такого-то плана, будет работать до такого-то момента, выключить её может этот человек и так далее. Если система сообщает это голосом, кто-то другой может это услышать. А если система сообщает конфиденциальную информацию?

Поэтому в своей работе мы решили не связываться с ситуациями, когда важны безопасность и приватность.

Крупные компании будут пытаться имитировать возможность ассистента ответить на любой вопрос, и это всё ещё не будет работать.

Применение будет возможно в узких сферах, где ожидания пользователя ограничивают его словарь и динамику взаимодействия. Например, билетному аппарату можно сказать, что нужен билет от Москвы до Калуги на завтрашний вечер. Если человек затем спросит, сколько лет Бараку Обаме, совершенно нормально, когда система не ответит на такой вопрос.

Будущее за фокусом на определённом пользовательском кейсе, поддержке всей связанной с ним грамматики и игнорировании всего, что за его пределами.

Голос используется для подтверждения платежей, но это лишь часть всего взаимодействия. Нет примеров, когда весь процесс можно пройти голосом. Отчасти это связано с юридическими особенностями и возвратом платежей.

В Европе есть cooldown period, когда в течение определённого времени (в разных странах оно разное) покупатель может вернуть товар, даже если с ним всё в порядке. Человек может поменять своё мнение без причины, и это поддерживается законом.

Платёжной системе также необходима гарантия, что человек оплатил продукт, зная, что он покупает, и это не ошибка. Если это ошибочная покупка, при возврате платежа действует совсем другое правило. Были случаи, когда ребёнок брал телефон (Amazon Fire), что-то говорил и запускал процесс покупки. В этом случае невозможно доказать, кто её инициировал.

Принято считать, что новая технология просто заменит предыдущую, но это не всегда так. Сейчас говорят о голосификации приложений, когда для существующего приложения экран просто заменяется голосом. Очевидно, это так не работает. В основном потому, что голос используется в других условиях. Если человек может держать телефон и нажимать на экран, он, скорее всего, не будет использовать голос. Тачскрин чаще всего удобнее ГИ.

Голос удобен тогда, когда сложно использовать телефон: за рулём, в дороге с сумками или дома на диване, когда телефон лежит на столе и просто лень вставать, чтобы взять его в руки. Включить музыку голосом оказывается проще, даже если нажать на кнопку — быстрее.

ГИ необходим тогда, когда использование телефона обычным способом невозможно, например, в автомобиле. Но если компания говорит, что продукт можно использовать во время вождения, ей надо доказывать специальным органам, что все законодательные ограничения, связанные с вождением, приняты во внимание.

ГИ необходимо использовать, когда соблюдается два условия:

Огромное преимущество визуальных интерфейсов в том, что варианты взаимодействия видны. С ГИ мы не знаем, что нам доступно.

Взаимодействие с экранами — очень хорошо проработанная тема. Экран останется даже тогда, когда ГИ будет работать хорошо, хотя бы потому, что у нас есть глаза. Визуальное восприятие — основное. Голосовое — вспомогательное.

Голос может взаимодействовать с экранным представлением данных и при этом не быть подчинённой структурой. Например, в Alexa основной компонент — голос. Можно поставить приложение, чтобы видеть ответы системы на экране (некоторые ответы сложно воспринимать на слух). Правда, сейчас концепция меняется — следующая версия Amazon Echo будет со своим экраном.

Хирург — хороший пример многозадачности. Он фокусируется на одном виде деятельности, но ему может требоваться дополнительная информация. Здесь ГИ применяется уже сейчас.

IBM с проектом Watson пошла по другому пути. Компания начала работать над искусственным интеллектом. Сначала он выиграл у людей в викторину, а четыре года назад его внедрили в нескольких американских клиниках. Сейчас его используют для диагностики рака в 1000 клиниках. Система используются для критических процессов, но в очень узких юзкейсах. При этом персонал проходит специальную подготовку.

Amazon запустил продукт, который кардинально отличался: нет экрана, это физический объект, качество голоса намного выше (за счёт встроенного хранилища данных с предзаписанными сэмплами).

Интересное диалоговое взаимодействие Google. Если мы говорим, что хотим добавить что-то в календарь, запустится система диалогов, достаточно гибкая и довольно очевидная. Она уточняет информацию о мероприятии, вы можете корректировать данные и так далее.

Microsoft хорошо решила вопрос настройки в Cortana. Ожидается, что человеку не надо ничего знать о системе и настраивать. Когда я говорю это, то обычно имею в виду следующее: вот эти слова я использую не так, как остальные люди, и так далее. По идее это должно работать автоматически, но не работает, а значит, должна быть система настройки.

Apple полностью игнорирует вопрос настроек. Для Cortana можно указать свои интересы и так далее, и при этом интерфейс достаточно простой.

Конспект подготовил проектировщик интерфейсов Антон Григорьев.